Gesichts-Scan: KI beurteilt Gesichter oft rassistisch

Autor: Ralf Nowotny

Wir brauchen deine Hilfe – Unterstütze uns!

In einer Welt, die zunehmend von Fehlinformationen und Fake News überflutet wird, setzen wir bei Mimikama uns jeden Tag dafür ein, dir verlässliche und geprüfte Informationen zu bieten. Unser Engagement im Kampf gegen Desinformation bedeutet, dass wir ständig aufklären und informieren müssen, was natürlich auch Kosten verursacht.

Deine Unterstützung ist jetzt wichtiger denn je.

Wenn du den Wert unserer Arbeit erkennst und die Bedeutung einer gut informierten Gesellschaft für die Demokratie schätzt, bitten wir dich, über eine finanzielle Unterstützung nachzudenken.

Schon kleine Beiträge können einen großen Unterschied machen und helfen uns, unsere Unabhängigkeit zu bewahren und unsere Mission fortzusetzen.

So kannst du helfen!

PayPal: Für schnelle und einfache Online-Zahlungen.

Steady: für regelmäßige Unterstützung.

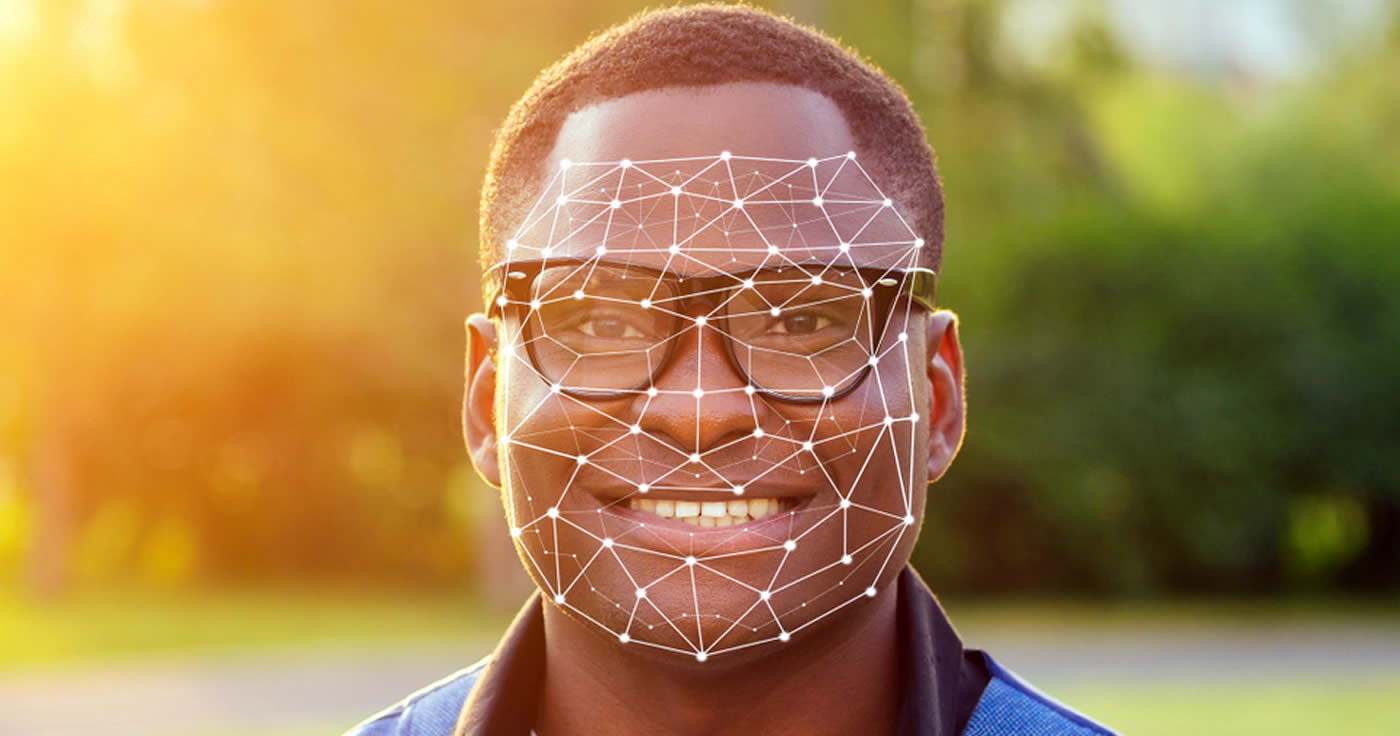

Die KI eines Kunstprojektes vergleicht mittels Gesichts-Scan das eigene Gesicht mit einer Datenbank und urteilt dabei häufig rassistisch.

Das Online-Kunstprojekt „ImageNet Roulette“ zeigt Internetnutzern, mit wie vielen Vorurteilen Künstliche Intelligenz (KI) in Bezug auf Gesichtserkennung durch einen Gesichts-Scan behaftet ist. Das Projekt wurde vom Künstler Trevor Paglen und der KI-Forscherin Kate Crawford ins Leben gerufen und soll User auf provokante Weise mit den Einschränkungen von KI konfrontieren.

Klassifizierung in nur einem Wort

Das Projekt will erforschen, „wie Menschen durch Datensets repräsentiert, interpretiert und kodifiziert werden, und wie technologische Systeme dieses Material sammeln und einordnen. Die Klassifizierung von Menschen durch KI wird immer komplexer, und dadurch zeigen sich auch ihre Vorurteile. In diesen Systemen wird aus der Einstufung schnell und heimlich ein moralisches Urteil“.

[mk_ad]

Um Gesichter zu erkennen, nutzt das Projekt die Forschungsdatenbank ImageNet, die jedem Bild ein Substantiv zuordnet. In dem Kunstprojekt zeigt sich, dass die Einschätzungen der Software über die Persönlichkeit der User in diesen Substantiven oft rassistische Klischees bedienen. Auf ImageNet Roulette ist es möglich, Fotos hochzuladen, die der ImageNet-Algorithmus dann auf Gesichter untersucht. Diese bewertet die KI schließlich nach ihrem scheinbar auffälligsten Charaktermerkmal. Diese Eigenschaften werden auf der Seite erläutert.

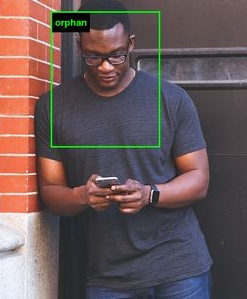

Schwarze Männer „Waisenkinder“

Im Test mit lizenzfreien Bildern schätzte die Seite farbige Männer häufig als „orphans“, also als Waisenkinder ein. Eine dunkelhäutige Frau wurde als „homegirl“ eingestuft, laut der Website handelt es sich dabei um ein weibliches Mitglied einer Gang. Einigen Twitter-Nutzern zufolge wurden dunkelhäutige Männer teilweise als „rape suspects“, also einer Vergewaltigung verdächtigt, eingestuft. Einen ersichtlichen Grund für diese Einschätzungen gibt es nicht.

Paglen und Crawford wollen mit ImageNet Roulette davor warnen, dass Gesichtserkennungs-Software oft mit problematischen Daten arbeitet. „Klassifizierungen durch KI sind für die betroffenen Personen selten sichtbar. ImageNet Roulette bietet einen Blick auf diesen Prozess und zeigt, was dabei schief gehen kann“, meint Paglen.

Quelle: pressetext

Artikelbild: Shutterstock / Von yurakrasil

FAKE NEWS BEKÄMPFEN

Unterstützen Sie Mimikama, um gemeinsam gegen Fake News vorzugehen und die Demokratie zu stärken. Helfen Sie mit, Fake News zu stoppen!

Mit Deiner Unterstützung via PayPal, Banküberweisung, Steady oder Patreon ermöglichst Du es uns, Falschmeldungen zu entlarven und klare Fakten zu präsentieren. Jeder Beitrag, groß oder klein, macht einen Unterschied. Vielen Dank für Deine Hilfe! ❤️

Mimikama-Webshop

Unser Ziel bei Mimikama ist einfach: Wir kämpfen mit Humor und Scharfsinn gegen Desinformation und Verschwörungstheorien.

Hinweise: 1) Dieser Inhalt gibt den Stand der Dinge wieder, der zum Zeitpunkt der Veröffentlichung aktuell

war. Die Wiedergabe einzelner Bilder, Screenshots, Einbettungen oder Videosequenzen dient zur

Auseinandersetzung der Sache mit dem Thema.

2) Einzelne Beiträge (keine Faktenchecks) entstanden durch den Einsatz von maschineller Hilfe und

wurde vor der Publikation gewissenhaft von der Mimikama-Redaktion kontrolliert. (Begründung)

Mit deiner Hilfe unterstützt du eine der wichtigsten unabhängigen Informationsquellen zum Thema Fake News und Verbraucherschutz im deutschsprachigen Raum

INSERT_STEADY_CHECKOUT_HERE

Kämpfe mit uns für ein echtes, faktenbasiertes Internet! Besorgt über Falschmeldungen? Unterstütze Mimikama und hilf uns, Qualität und Vertrauen im digitalen Raum zu fördern. Dein Beitrag, egal in welcher Höhe, hilft uns, weiterhin für eine wahrheitsgetreue Online-Welt zu arbeiten. Unterstütze jetzt und mach einen echten Unterschied! Werde auch Du ein jetzt ein Botschafter von Mimikama

Mehr von Mimikama

Mimikama Workshops & Vorträge: Stark gegen Fake News!

Mit unseren Workshops erleben Sie ein Feuerwerk an Impulsen mit echtem Mehrwert in Medienkompetenz, lernen Fake News und deren Manipulation zu erkennen, schützen sich vor Falschmeldungen und deren Auswirkungen und fördern dabei einen informierten, kritischen und transparenten Umgang mit Informationen.