Deepfake-Video: Mordopfer sucht „selbst“ seinen Mörder

Erst kürzlich machte die Deepfake-Technologie wieder Schlagzeilen, diesmal im Mordfall Sedar Soares.

Wir brauchen deine Hilfe – Unterstütze uns!

In einer Welt, die zunehmend von Fehlinformationen und Fake News überflutet wird, setzen wir bei Mimikama uns jeden Tag dafür ein, dir verlässliche und geprüfte Informationen zu bieten. Unser Engagement im Kampf gegen Desinformation bedeutet, dass wir ständig aufklären und informieren müssen, was natürlich auch Kosten verursacht.

Deine Unterstützung ist jetzt wichtiger denn je.

Wenn du den Wert unserer Arbeit erkennst und die Bedeutung einer gut informierten Gesellschaft für die Demokratie schätzt, bitten wir dich, über eine finanzielle Unterstützung nachzudenken.

Schon kleine Beiträge können einen großen Unterschied machen und helfen uns, unsere Unabhängigkeit zu bewahren und unsere Mission fortzusetzen.

So kannst du helfen!

PayPal: Für schnelle und einfache Online-Zahlungen.

Steady: für regelmäßige Unterstützung.

Ein Teenager geht auf einem Fußballplatz durch ein Spalier aus Familie, Freunden, Lehrern und Trainern. Dieses Polizeivideo ist eine Weltpremiere. Mithilfe eines Deepfake-Videos sucht die niederländische Polizei aus Rotterdam nach dem Mörder von Sedar Soares. Das Besondere an dem Film: Das Opfer selbst sucht nach dem Täter.

Achtung Deepfake: Wie künstliche Intelligenz Stimmen täuschend echt nachahmt

Das Klonen von Stimmen wurde erst vor Kurzem erfunden, aber die Technologie zeigt bereits beeindruckende Ergebnisse. Dabei geht es nicht

nur um Parodien von Prominenten. Friendsurance untersucht, wem und wie Deepfakes helfen und welche Gefahr sie bedeuten. Jeder Nutzer hat schon einen Zugang zur Deepfake Software Ein Deepfake ist das täuschend echte Nachahmen (Fälschen) von Video-, Audio– oder Fotoinhalten. Es ist das Ergebnis einer Manipulation durch Technologie (durch Künstliche Intelligenz, abgekürzt KI). Ian Goodfellow, Direktor für maschinelles Lernen bei der Apple Special Projects Group, prägte den Begriff “Deepfake” 2014, als er noch Student an der Stanford University war. Der Begriff entstand aus einer Kombination des ersten Teils von “Deep Learning” und dem Wort “Fake”.

Deepfake entwickelt einen generativen und kontradiktorischen Algorithmus. Er lernt wie ein Mensch aus seinen eigenen Fehlern, als würde er mit sich selbst konkurrieren. Das System “schimpft” den Algorithmus für Fehler und “belohnt” ihn für richtige Handlung, bis er die genaueste Fälschung produziert.

Mit der Weiterentwicklung der KI-Technologie wird die Deepfake-Erstellung immer einfacher. Um einen Sprachklon zu schaffen, muss man lediglich seine Stimme eine gewisse Zeit lang aufzeichnen, ohne dass es zu Aussetzern oder anderen Störungen kommt. Dann wird die Datei zur Bearbeitung an ein Unternehmen geschickt, das einen solchen Dienst anbietet, oder vom Sprecher selbst in ein spezielles Programm hochgeladen. Mehrere Start-ups bieten bereits solche Dienste an: Resemble, Descript, CereVoice Me und andere.

Vor einigen Jahren wurden realistische Deepfakes erstellt, indem man die Stimme einer Person aufnahm, ihre Sprache in die einzelnen Laute zerlegte und sie dann zu neuen Wörtern kombinierte. Heute können neuronale Netze mit einem Satz von Sprachdaten beliebiger Qualität und Lautstärke trainiert werden. Dank des kontradiktorischen Prinzips kann ein neuronales Netz echte menschliche Sprache schneller und genauer erkennen. Während früher Dutzende oder gar Hunderte von Stunden an Audiomaterial benötigt wurden, können jetzt realistische Stimmen aus nur wenigen Minuten an Audioinhalten erzeugt werden. Die Unternehmen wollen die Technologie vermarkten und bieten sie bereits für einige Anwendungen an.

Deepfake-Werbespots, -Filme und -Synchronisation

Veritone hat im Frühjahr 2021 einen Dienst namens marvel.ai zur Erstellung und Monetarisierung von Sprachfälschungen gestartet. Die Technologie ermöglicht es den Influencern, Sportlern und Schauspielern, die Verwendung ihrer Stimmen zu lizenzieren. So können Produkte (z.B. Werbespots) mit deren Stimmen kreiert werden, ohne das Studio besuchen zu müssen. Das Unternehmen garantiert mit Hilfe von eingebetteten “Wasserzeichen”, dass der Deepfake nicht kopiert und illegal verwendet werden kann. Die von dem Unternehmen erstellten Voice Deepfakes können im Tonfall oder Geschlecht angepasst, sowie in andere Sprachen übersetzt werden.

Seit Anfang 2021 bietet Microsoft seinen Partnern einen ähnlichen Dienst an. Die Microsoft Azure AI-Plattform kann die Stimmen von Prominenten so synthetisieren, dass sie von den Originalen nicht zu unterscheiden sind. So begrüßt beispielsweise das US-Telekommunikationsunternehmen AT&T in einem Erlebnisladen in Dallas die Besucher mit der Stimme von Bugs Bunny. Er begrüßt jeden Gast mit Namen und unterhält sich mit ihm, während er einkauft. Der Synchronsprecher nahm 2.000 Sätze für Microsoft auf, um Bugs Bunny eine Stimme zu geben

Podcasts und Audiobücher

Die Software von Descript zur Podcast-Bearbeitung enthält eine Overdub-Technologie. Diese Funktion ermöglicht einem Podcaster, einen KI-Klon seiner Stimme zu erstellen, damit Produzenten die Folgen schnell bearbeiten können. Sie hilft nicht nur dabei, unnötige Wörter zu löschen, sondern auch, sie durch neue zu ersetzen. Um Descript zu verwenden, muss man lediglich die gewünschte Textmenge “sprechen”. Das Tool wird bereits von Pushkin Industries eingesetzt, das mit Podcastern und Audio-Erzählern wie Malcolm Gladwell (Revisionist History), Michael Lewis (Against the Rules) und Ibram X. Kendi (Be Antiracist) zusammengearbeitet hat.

Bedrohung durch Deepfakes

Forscher von SAND Lab (Universität Chicago) haben eine Sprachsynthese-Software getestet, die auf der Open-Source-Entwicklerplattform Github verfügbar ist. Es hat sich herausgestellt, dass sie die Sprachassistenten Amazon Alexa, WeChat und Microsoft Azure Bot täuschen können. Das Programm SV2TTS benötigt nur 5 Sekunden, um eine ziemlich gute Simulation zu erstellen. Die Software konnte den Microsoft Azure-Bot in etwa 30 % der Fälle täuschen, während die Sprachassistenten von WeChat und Amazon Alexa in 63 % der Fälle nicht in der Lage waren, den Deepfake zu erkennen. Von den teilnehmenden Freiwilligen konnte mehr als die Hälfte der 200 Befragten den Deepfake nicht heraushören.

Forscher sehen darin eine ernsthafte Bedrohung in Form von Betrug und Angriffen auf ganze Systeme. Bei WeChat können sich die Nutzer beispielsweise mit ihrer Stimme bei einem Konto anmelden, und mit Alexa lassen sich Zahlungen per Sprachbefehl durchführen. Ähnliche Geschichten haben sich bereits mehrfach zugetragen. 2019 nutzten Betrüger einen Voice-Deepfake, um eine Führungskraft eines britischen Energieunternehmens zu betrügen. Der Mann war überzeugt, einen Anruf von seinem deutschen Chef zu erhalten, und überwies den Betrügern über 240.000 US $.

Unternehmen, die Deepfakes als Dienstleistung anbieten, leugnen nicht, dass sie böswillig verwendet werden können. Dabei bieten sie einen Service an, mit dem virtuell lebensechte Stimmen erzeugt werden können. Das in San Francisco gegründete Unternehmen Lyrebird behauptet beispielsweise, „die realistischsten künstlichen Stimmen der Welt“ erzeugen zu können. Und das alles mit der Software von Descript, die nach dem Hochladen einer einminütigen Aufnahme einen Stimmenklon erstellt.

Das Problem bei der kommerziellen Nutzung von Sprach-Deepfakes ist, dass es in keinem Land der Welt ein Urheberrecht an der menschlichen Stimme gibt. Das Rechtsproblem der Verstorbenen in Bezug auf die Verwendung ihrer Stimme ist ebenfalls noch offen. Außerdem gibt es bisher in keinem Land eine Gesetzgebungspraxis, die das Verfahren zur Entfernung von Deepfakes beeinflussen könnte. In den USA und in China werden derzeit Gesetze über ihre Verwendung ausgearbeitet. So hat Kalifornien beispielsweise die Verwendung von Deepfakes in der Werbung verboten.

Die einzige Ausnahme ist, wenn der Name einer Person als kommerzielle Marke registriert ist. In der Regel handelt es sich dabei um Prominente. 2020 stellte der amerikanische YouTube-Kanal Vocal Synthesis mehrere humorvolle Aufnahmen ohne kommerziellen Nutzen von Texten des Rappers Jay-Z ein. Alle Videos waren mit Untertiteln versehen, aus denen hervorging, dass die Rede des Prominenten synthetisiert worden war. Das Konzertunternehmen RocNation, das Jay-Z gehört, reichte jedoch eine Klage wegen Urheberrechtsverletzung ein und verlangte, dass die Videos entfernt werden. Letztendlich wurden nur zwei von vier Videos mit Jay-Z entfernt, da es sich bei den anderen beiden Tonprodukten um abgeleitete Werke handelte, die nichts mit den Rapper-Songs zu tun hatten.

Ethische Fragen

Deepfakes können auch für sinnvolle Zwecke eingesetzt werden. Es ergeben sich jedoch auch ethische Probleme. So wurde beispielsweise der

Dokumentarfilm “Roadrunner: A Film about Anthony Bourdain” über den Koch Anthony Bourdain von Kritikern und Publikum gleichermaßen als

unethisch bezeichnet. Die Filmemacher benutzten Bourdains von einem neuronalen Netz erzeugte Stimme und synchronisierten Sätze, die der Koch nie wirklich gesagt hat. Filmkritiker, die davon nichts wussten, verurteilten die Autoren ebenfalls und bezeichneten ihr Vorgehen als Betrug und Manipulation des Publikums.

In der Zwischenzeit hat Sonantic bekannt gegeben, dass sie einen Stimmklon des Schauspielers Val Kilmer erstellt haben, der nach einem Luftröhrenschnitt als Teil seiner Kehlkopfkrebs-Behandlung kaum noch sprechen kann. Das Team verwendete sein eigenes KI-Modell Voice Engine. Der Schauspieler ist dafür sehr dankbar. Sonantic weist darauf hin, dass die firmeneigene App es Kreativteams ermöglicht, Text einzugeben und dann wichtige Parameter wie Tonhöhe und Tempo anzupassen.

Welche Perspektiven hat die Nutzung?

Stimmspezialisten und Sprecher sind der Meinung, dass Deepfakes für die maschinelle Verarbeitung von Stimmen sehr nützlich sein können: in

Messengern, bei Durchsagen usw. Aber sie können nicht mit echten Menschen mithalten, wenn “menschliche” Emotionen gefragt sind. Die Unternehmen arbeiten jedoch bereits auch daran: Z.B. schlägt Resemble AI bereits vor, bei der Erstellung von Deepfake eine Form der Modulation zu verwenden, die die Intonation verändert und der Sprache Emotion verleiht.

TikTok war das erste soziale Netzwerk, das schon Ende 2020 eine automatische Voice-over-Funktion für Textnachrichten anbot. Allerdings musste die Synchronisation geändert werden. Es stellte sich heraus, dass die synthetische Frauenstimme tatsächlich einer realen Person gehörte, der Synchronsprecherin Bev Standing, die zuvor mit dem chinesischen Institut für Akustik zusammengearbeitet hatte. Die Frau hat TikTok verklagt.

Deepfake-Technologien selbst fügen eigentlich keinen Schaden zu. Es kommt auf den Zweck an, für den sie eingesetzt werden. So könnte beispielsweise die KI-Technologie benutzt werden, um die Stimme von Menschen wiederherzustellen, die sie aufgrund einer Krankheit verloren haben.

Hinzu kommt, dass viele Menschen die Deepfake-Technologie schon tagtäglich nutzen. Aber wahrscheinlich liegt das nicht so klar vor den Augen, dass es sich dabei ebenfalls um Deepfake handelt: Es geht um Sprachassistenten. Alexa, Google Assistant, Siri, Cortana, Alisa, Bixby und so weiter und so fort. Sie helfen uns bei der Suche nach Informationen, lesen E-Books vor und können Smart Home System steuern. Sind sie denn gefährlich? Die Antwort in diesem Fall könnte so sein: Ein Satz von Algorithmen und Code an sich ist nicht gefährlich. Leider ist der Mensch dafür verantwortlich, der diesen Code zum Guten oder zum Schlechten nutzen kann.

Einige Tipps der Versicherungsexperten von Friendsurance: Da ein Smartphone das gängigste Gerät für den Empfang und die Übertragung von Sprachinformationen ist, empfehlen unsere Experten eine Reihe von einfachen Schutzmaßnahmen. Es ist wichtig, nicht nur auf die Datensicherheit zu achten, sondern auch auf die physische Sicherheit Ihres Handys.

Ein wichtiger Schritt ist daher auch das Smartphone im Alltag zu schützen, z.B. durch:

- den Startbildschirm (Passwort oder biometrische Daten)

- Passwortvergabe für jede App, die sensible Daten enthält

- Regelmäßige Backups Ihrer Daten

- Lassen Sie Ihr Gerät nicht unbeaufsichtigt, selbst für kurze Zeit. Legen Sie es zum Beispiel nicht auf den Tisch, wenn Sie durch die Sicherheitskontrolle am Flughafen oder am Bahnhof gehen (stecken Sie es lieber in Ihre Tasche). Es besteht die Gefahr von Diebstahl und Beschädigung.

- Tragen Sie Ihr Handy an einem sicheren Ort, näher am Körper. Verzichten Sie auf die Idee, Ihr Gerät in der Gesäßtasche der Hose oder im Außenfach des Rucksacks zu tragen.

- Nicht zuletzt sollten Sie an eine Handyversicherung denken. Wenn Ihrem Gerät etwas zustößt, haben Sie die Möglichkeit, es ohne zusätzliche Kosten reparieren zu lassen oder im Falle eines Totalschadens sogar ein neues Gerät zu bekommen. Als Faustregel gilt, dass Handyversicherung-Preise viel niedriger sind, als wenn Sie die Reparaturkosten zu 100 % aus eigener Tasche bezahlen müssten

Passend zum Thema:

Österreich: Bundesregierung legt Aktionsplan gegen Deepfakes vor

und

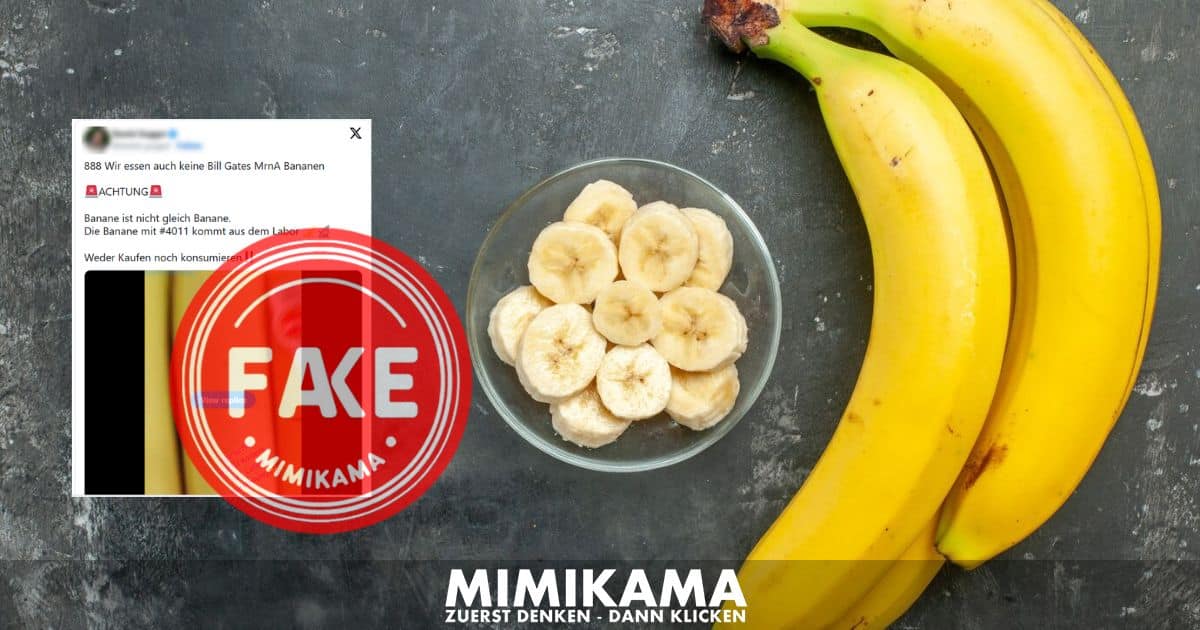

FAKE NEWS BEKÄMPFEN

Unterstützen Sie Mimikama, um gemeinsam gegen Fake News vorzugehen und die Demokratie zu stärken. Helfen Sie mit, Fake News zu stoppen!

Mit Deiner Unterstützung via PayPal, Banküberweisung, Steady oder Patreon ermöglichst Du es uns, Falschmeldungen zu entlarven und klare Fakten zu präsentieren. Jeder Beitrag, groß oder klein, macht einen Unterschied. Vielen Dank für Deine Hilfe! ❤️

Mimikama-Webshop

Unser Ziel bei Mimikama ist einfach: Wir kämpfen mit Humor und Scharfsinn gegen Desinformation und Verschwörungstheorien.

Hinweise: 1) Dieser Inhalt gibt den Stand der Dinge wieder, der zum Zeitpunkt der Veröffentlichung aktuell

war. Die Wiedergabe einzelner Bilder, Screenshots, Einbettungen oder Videosequenzen dient zur

Auseinandersetzung der Sache mit dem Thema.

2) Einzelne Beiträge (keine Faktenchecks) entstanden durch den Einsatz von maschineller Hilfe und

wurde vor der Publikation gewissenhaft von der Mimikama-Redaktion kontrolliert. (Begründung)

Mit deiner Hilfe unterstützt du eine der wichtigsten unabhängigen Informationsquellen zum Thema Fake News und Verbraucherschutz im deutschsprachigen Raum

INSERT_STEADY_CHECKOUT_HERE

Kämpfe mit uns für ein echtes, faktenbasiertes Internet! Besorgt über Falschmeldungen? Unterstütze Mimikama und hilf uns, Qualität und Vertrauen im digitalen Raum zu fördern. Dein Beitrag, egal in welcher Höhe, hilft uns, weiterhin für eine wahrheitsgetreue Online-Welt zu arbeiten. Unterstütze jetzt und mach einen echten Unterschied! Werde auch Du ein jetzt ein Botschafter von Mimikama

Mehr von Mimikama

Mimikama Workshops & Vorträge: Stark gegen Fake News!

Mit unseren Workshops erleben Sie ein Feuerwerk an Impulsen mit echtem Mehrwert in Medienkompetenz, lernen Fake News und deren Manipulation zu erkennen, schützen sich vor Falschmeldungen und deren Auswirkungen und fördern dabei einen informierten, kritischen und transparenten Umgang mit Informationen.